Cinco investigadores portugueses estão a participar num projeto europeu inédito com o propósito de criar dispositivos artificiais capazes de compreender a linguagem animal.

Cinco investigadores portugueses estão a participar num projeto europeu inédito com o propósito de criar dispositivos artificiais capazes de compreender a linguagem animal, o que poderá lançar bases para a administração do ambiente das sociedades animais através da robótica.

Em declarações à Lusa, Luís Correia, investigador do Laboratório de Modelação de Agente da Universidade de Lisboa, a única instituição portuguesa a participar no projeto europeu FOCAS (Fundamentos de Sistemas Adaptativos Coletivos), os robôs que estão a ser desenvolvidos vão adaptar-se ao meio animal por intermédio de algoritmos evolutivos até aprenderem a interagir com os animais.

De acordo com o especialista, a inovação poderá conduzir ao desenvolvimento de robôs ou dispositivos que interajam com animais que 'funcionam' em coletivo, como os rebanhos, permitindo apurar se tais dispositivos “têm alguma influência” nos seus comportamentos e interações.

“Nós tentamos fazer interagir as populações em ambientes animais e meios diferentes. Por exemplo, as abelhas no solo – em terrenos tipo colmeias – e os animais na água por via de dispositivos artificiais e do meio digital”, exemplificou Luís Correia.

Outra das tarefas do projeto “é precisamente fazer com que os dispositivos tenham alguma capacidade de adaptação, ou seja, de mudarem eles próprios o seu comportamento em função das interações que têm com as populações animais”, acrescentou.

Ensaios já realizados com abelhas e peixes-zebra

A investigação deverá terminar em 2018, mas, caso fique comprovada a viabilidade desta abordagem, a mesma “poderá ter implicações interessantes e úteis na agricultura, em particular em pastagens, no controlo de pestes e noutro tipo de intervenções em que haja interação de animais em coletivos”, antecipou o cientista português.

Desde que o projeto arrancou, o ano passado, os especialistas já realizaram testes com robôs chamados Unidade de Atuação e Perceção (CASUS, na sigla em inglês), que não se movem e que interagiram com abelhas reais comuns produtoras de mel, relativamente jovens, ainda incapazes de voar.

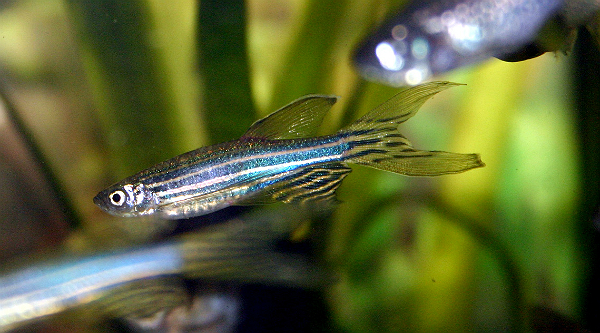

A equipa realizou igualmente ensaios em aquários com peixes-zebra (vertebrados com proximidade genética com o ser humano, em particular ao nível do aparelho ocular), recorrendo a dispositivos individuais para poder ter a noção das interações e dos comportamentos e medir as reações dos peixes e o comportamento dos dispositivos artificiais.

“Temos uns robôs muito rudimentares que vibram, apenas, e com a vibração conseguem mover-se no terreno como se estivessem a andar no chão. Pusemos estes dispositivos a interagir com os nossos CASUS simulando os dispositivos das abelhas e os CASUS detetaram algum tipo de proximidade, portanto já nos permitiu fazer algum tipo de ensaio”, sublinhou Luís Correia.

Segundo o investigador da Universidade de Lisboa, as fases seguintes do trabalho da equipa internacional vão passar pelo desenvolvimento de protótipos em quantidade.

“Vamos ter, em princípio, na ordem de 60 CASUS para interagir com abelhas e na ordem de 20 para interagir com os peixes. E, depois, [vamos] desenvolver o comportamento coletivo dos dispositivos artificiais e fazê-los interagir coletivamente com as populações de peixes”, concluiu.

Notícia sugerida por Maria Manuela Mendes